- Home

- FEATURES

- Crawl Budget

- Status Codes

- Business-relevante Seiten

- Crawl Frequenz

- Crawl Budget Verschwendung

- Top-50 URLs

- Top-50 Ressourcen

- Top-10 Verzeichnisse

- Selbst definierte Gruppen

- Top-10 Produkte

- Gecrawlte Parameter

- HTTP vs. HTTPs Crawls

- Unterschiedliche Googlebots

- Content Typen

- Crawl-Budget Optimierung

- Google’s Indexierungsprozess

- Preise

- FAQ

- Über uns

- News & Co.

- EN

- Demo-Zugang

- Free Info Call

Den Googlebot immer im Blick

Einzigartige Funktionen und eine Logdatenspeicherung von bis zu 5 Jahren ermöglichen unerkannte Optimierungspotenziale. 100% DSGVO konform.

(1/2) @g33konaut @methode @JohnMu The past few weeks I've been my own crawler & indexer, collecting data from all sorts of specific resources over the internet & podcasts to put together a big picture of the Google indexing process. It's of course incomplete & greatly simplified! pic.twitter.com/5NmJI26pNW

— Jan-Peter Ruhso (@JanRuhso) October 29, 2021

Features im Detail

Mit dem Laden des Videos akzeptieren Sie die Datenschutzerklärung von YouTube.

Mehr erfahren

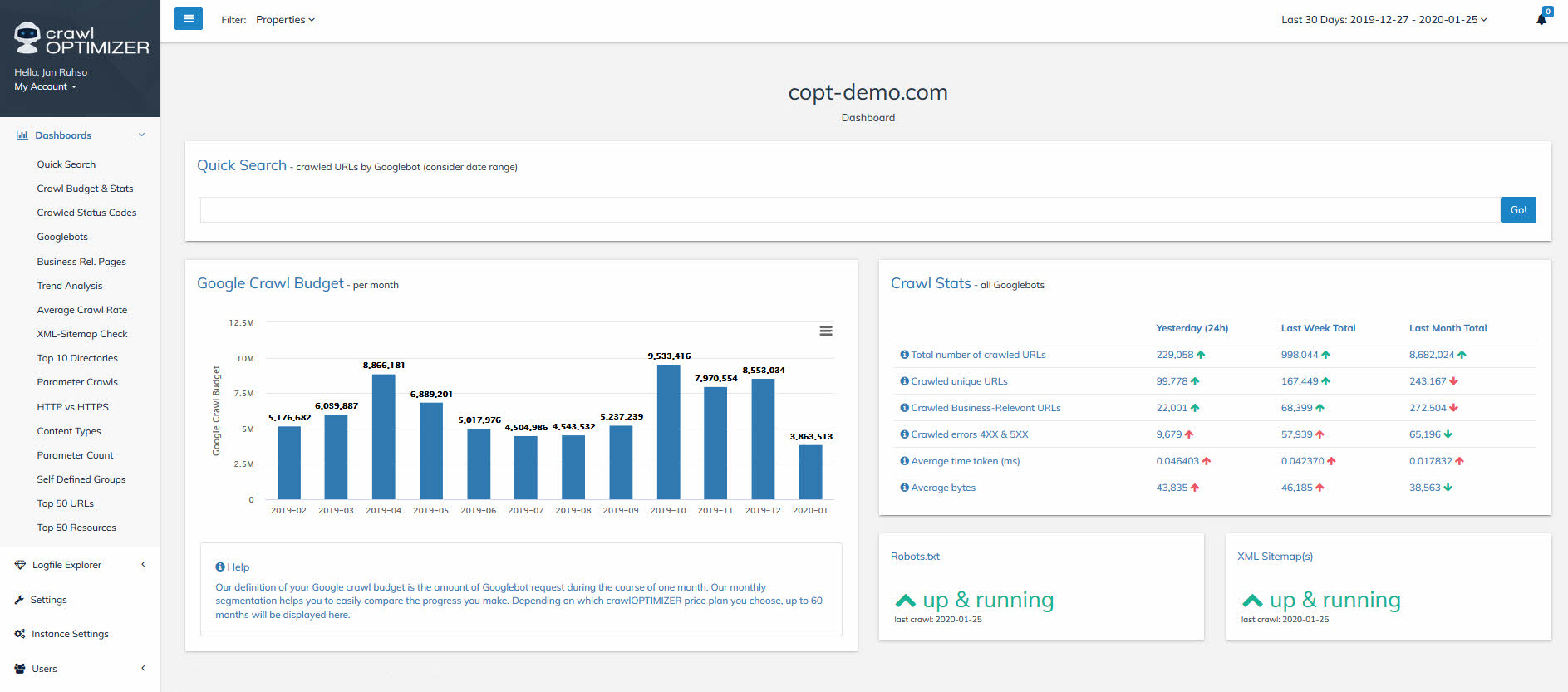

In dieser Übersicht siehst Du, wie sich Dein Crawl-Budget (oder auch Crawl-Volumen genannt) auf Monatsbasis geändert hat. Wir betrachten bewusst immer einen Monat, um eine Vergleichbarkeit zu ermöglichen und um so Trends auf einen Blick zu erkennen. Extreme Steigerungen oder Abfälle sind meist Indikatoren für Crawling-Probleme oder Google-Updates. Durch die Logdatenspeicherung von bis zu 5 Jahren können so wunderbar Trends, Langzeitentwicklungen & Optimierungserfolge festgestellt werden.

Wir definieren „Crawl-Budget“ bewusst etwas anders, als Google diesen Begriff offiziell definiert: Bei uns steht der Begriff Crawl-Budget für die Gesamtanzahl der Googlebot-Requests binnen einem Monat.

Weiteres findest Du in den Statistiken aktuelle Crawl-Trends, im Vergleich zum Vortag, Vorwoche und Vormonat. Hier werden alle Hard-Facts zusammengefasst und verglichen:

• Gesamtanzahl Googlebot Requests

• Anzahl gecrawlte Unique-URLs

• Anzahl gecrawlte Business-relevante URLs

• Anzahl gecrawlte Errors (Status Codes 4xx und 5xx)

• Durchschnittliche Download-Ladezeit einer URL

• Durchschnittliche Größe einer URL in Kilobyte

Abschließend siehst Du hier noch, ob Deine „Robots.txt“ und Deine „XML-Sitemap(s)“ gecrawlt wurden.

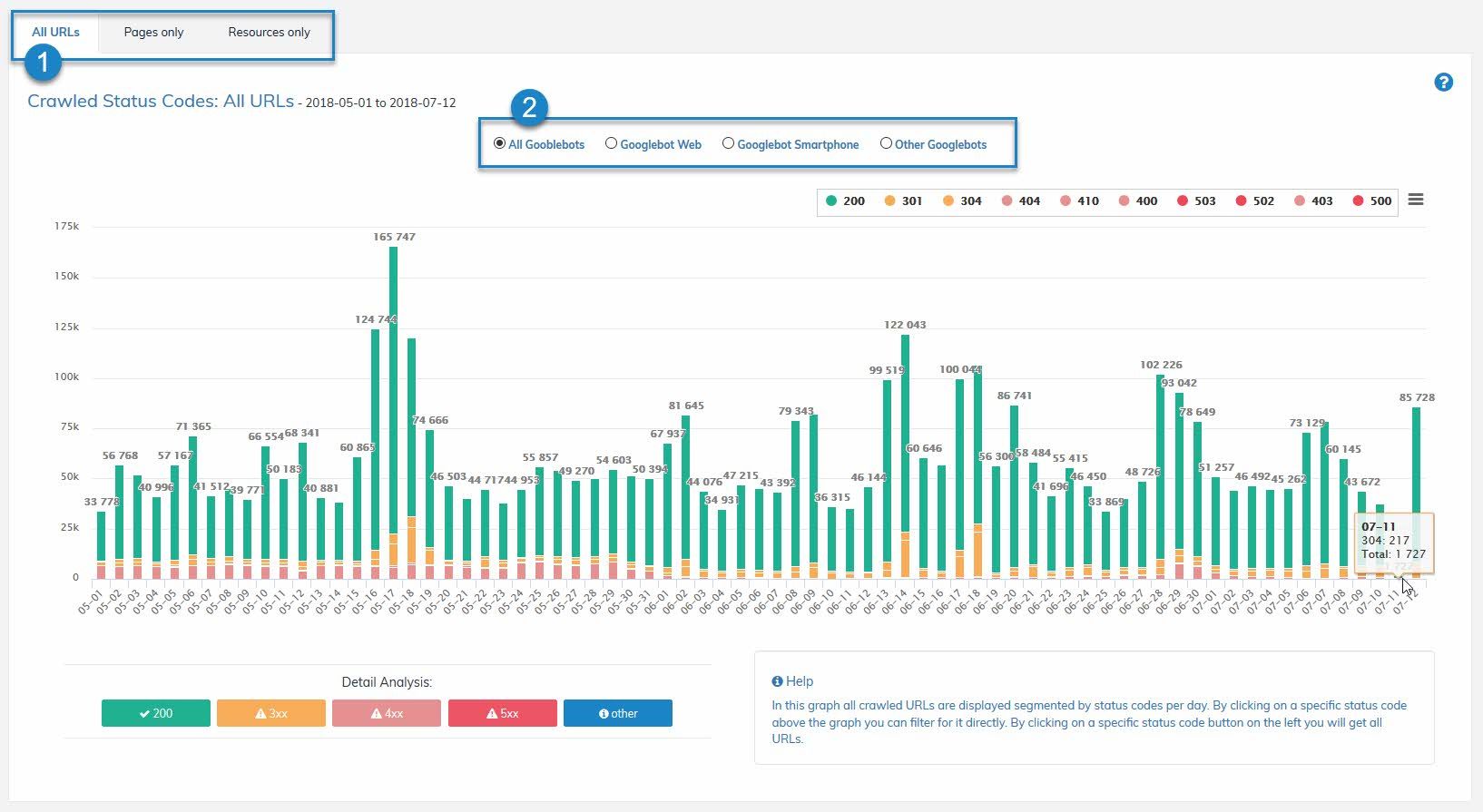

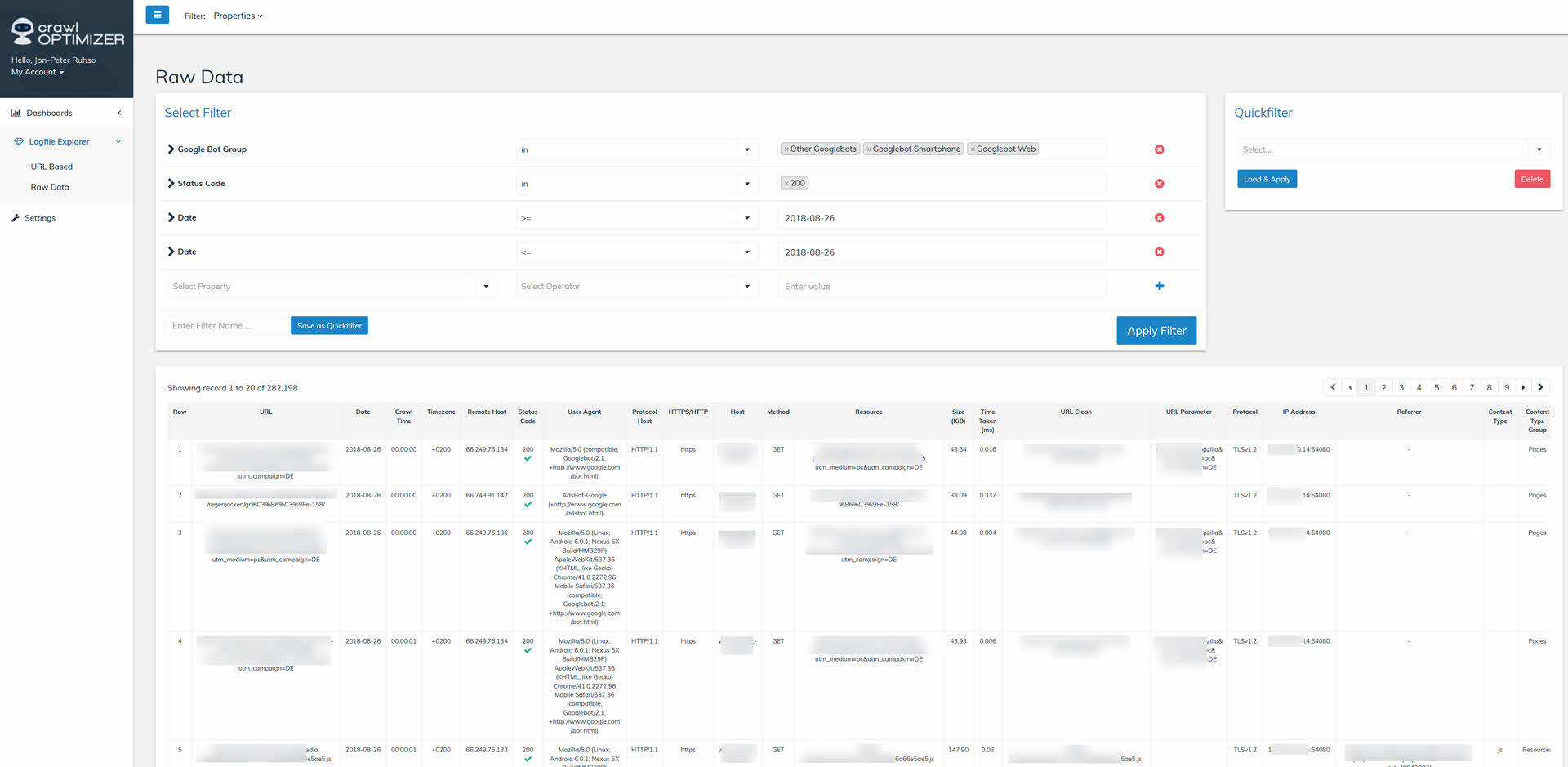

Bei Crawled Status Codes siehst Du auf Tagesebene die Anzahl der gecrawlten, unterschiedlichen Status Codes, um Crawling-Fehler sofort zu erkennen. Du hast zusätzlich folgende Filtermöglichkeiten:

- Alle URLs oder Nur Seiten oder Nur Ressourcen

- Googlebot Web (desktop) oder Googlebot Smartphone oder Andere Googlebots

Wenn Du nun im Graphen mit Deinem Cursor auf einen bestimmten Balken klickst (z.B. Status Code 200), wirst Du automatisch in unseren Logfile Explorer (RAW DATA) weitergeleitet. Dort findest Du dann alle Requests vorgefiltert (Status Code, Googlebot Group & Datum). Siehe Screenshot unterhalb.

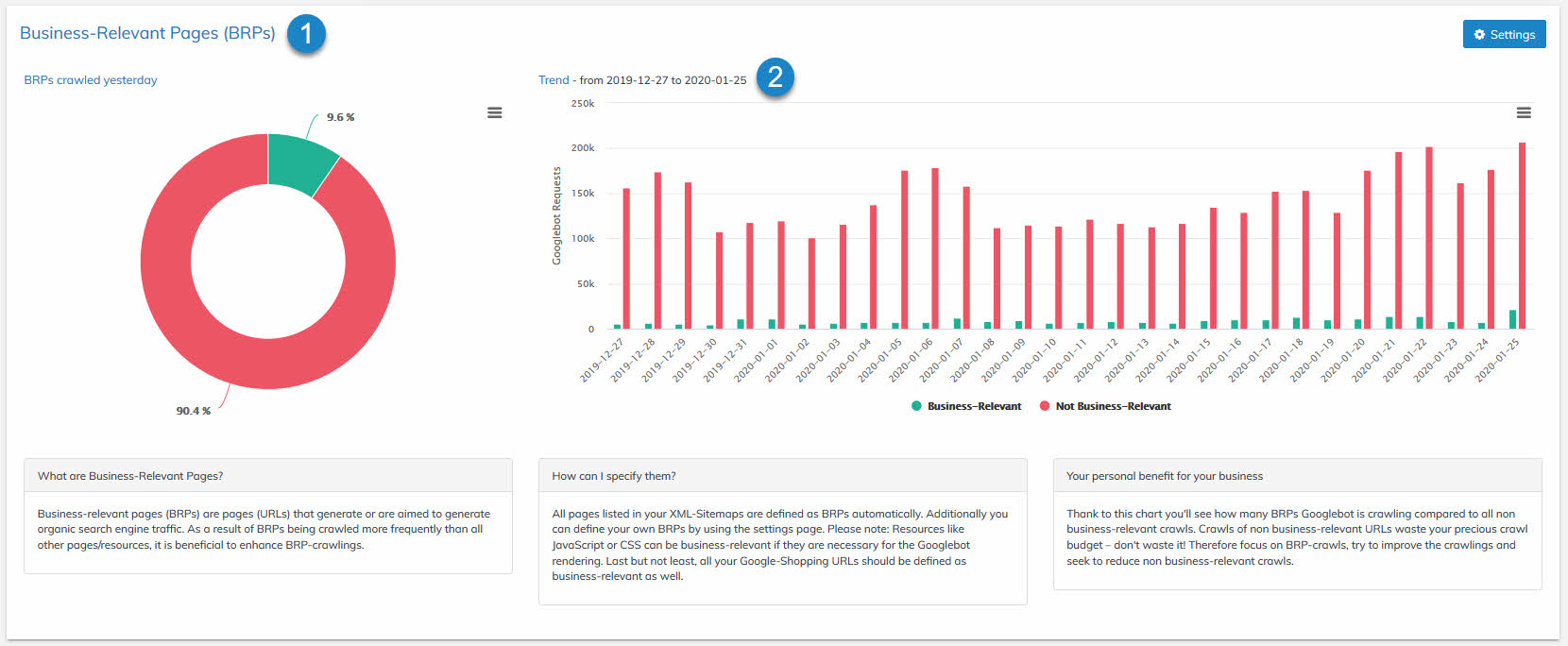

3. Business-relevante Seiten

Was sind Business-relevante Seiten?

Unter Business-relevanten Seiten definieren wir alle Seiten einer Webseite, die aus unternehmerischer Sicht wichtig sind und einen wirtschaftlichen Zweck erfüllen sollen (z.B. Newsartikel, Kategorieseiten, Markenseiten, Produktdetailseiten uvm). Um diesen wirtschaftlichen Zweck zu erfüllen, müssen diese Seiten in den Google-Suchergebnissen organischen Suchmaschinen-Traffic generieren und zuguterletzt Suchintensionen der Suchenden bestmöglich befriedigen. Aus diesen genannten Gründen sollten grundsätzlich nur Business-relevante Seiten von Bots gecrawlt werden, denn alle anderen Crawls auf nicht Business-relevante Seiten wären reine Verschwendung der ohnehin limitierten und daher kostbaren Googlebot Requests.

So definierst Du Deine Business-relevanten Seiten im crawlOPTIMIZER

Info: Die Definition der Business-relevanten Seiten ist eine einmalige Sache und sollte zum Start erledigt werden.

Wenn Deine Webseite über eine oder mehrere XML-Sitemap(s) verfügt, kannst Du sie in den SETTINGS im crawlOPTIMIZER hinterlegen und alle URL-Einträge aus den Sitemaps sind dann im System automatisch als „Business-relevant“ markiert.

Weiteres kannst Du in den SETTINGs im crawlOPTIMIZER in einem Freitextfeld manuell „URLs“ und/oder „Parameter“ als Business-relevant hinzufügen (z.B. URLs zu Ressourcen, die der Googlebot für das Rendering benötigt oder alte URLs die über Backlinks verfügen. Ein weiteres Beispiel sind Produktdetailseiten mit speziellen Tracking-Parametern, die für Google-Shopping ausgelegt sind – auch diese URLs sind Business-relevant, da sie vom normalen Googlebot gecrawlt werden). In den SETTINGS kannst Du auch mittels REGEX-Anweisungen weitere URLs als Business-relevant flaggen.

Tipp: Manchmal kann es gewollt sein, dass NOINDEX-Seiten gecrawlt werden zwecks Vererbung des Linkjuices zum Beispiel. Achte daher bitte gezielt auf solche eher seltenen Ausnahmen.

Einmalig definiert, geht´s los mit den Analysen

- Unter Business Relevant Pages (BRP) (siehe Punkt 1) siehst Du immer den gestrigen Crawl. Dort wird anteilig angezeigt, wie viel Prozent Deiner Business-relevanten Seiten tatsächlich vom Googlebot sauber gecrawlt wurden. Mit einem Klick auf das Tortendiagramm erhältst du vollautomatisch die Rohdaten im Logfile Explorer dargestellt.

- Beim Trend (siehe Punkt 2) siehst Du die Entwicklung auf Tagesebene der letzten 30 Tage (default). Du siehst auf einen Blick, ob Deine Optimierungsmaßnahmen bereits Früchte tragen, oder ob neue Crawling-Issues hinzugekommen sind. Wenn Du auf einen Balken im Graphen klickst, bekommst Du automatisch alle Rohdaten vorgefiltert im Logfile Explorer dargestellt. So kannst Du mit einem Klick sehen, welche z.B. NON-BRP-URLs gestern gecrawlt wurden.

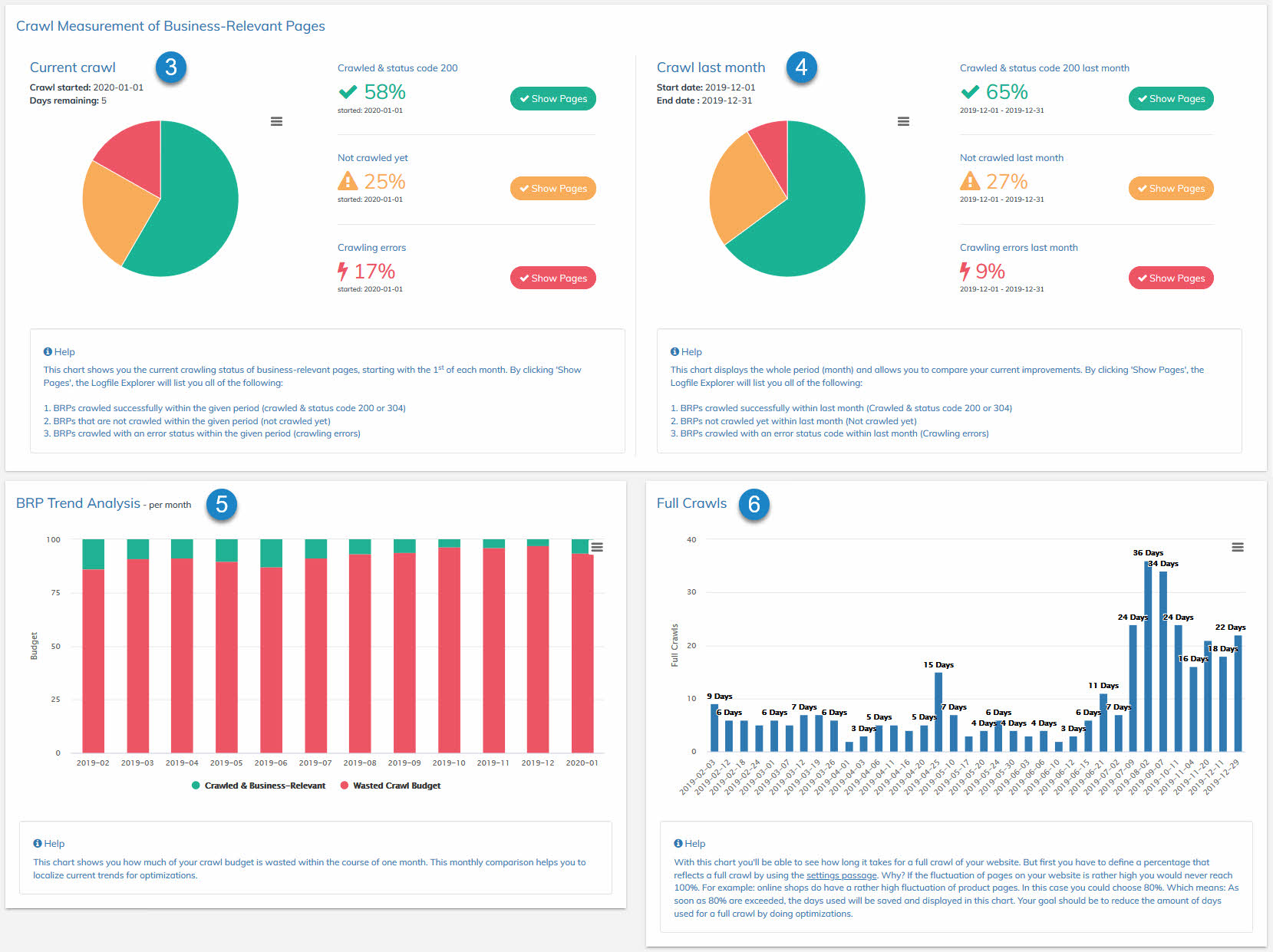

- Unter Current Crawl (siehe Punkt 3) sieht man auf einen Blick, wie viel Prozent der Business-relevanten Seiten seit dem 1. eines jeden Monats gecrawlt wurden. Wir betrachten immer einen gesamten Monat, um eine Vergleichbarkeit zu gewährleisten. Du kannst Dir alle URLs anzeigen lassen, indem Du auf einen der Buttons „Show Pages“ klickst.

- Sobald ein Monat vorbei ist, sieht man die Werte des Vormonats unter Crawl Last Month (siehe Punkt 4). Auch hier wieder aufgelistet im Logfile Explorer mit Hilfe der Buttons „Show Pages“.

- Bei Trend Analysis (siehe Punkt 5) werden die zuvor gesammelten Informationen auf Monatsebene übersichtlich dargestellt, um eine visuelle Langzeitentwicklung darzustellen.

- Bei Full Crawls (siehe Punkt 6) kannst Du selbst definieren, bei wie viel Prozent ein „voller Crawl“ erreicht ist. 100% sind bei sehr großen Webseiten oder Online-Shops aufgrund diverser Seitenfluktuationen nur schwer zu erreichen. Daher sollte ein Wert bestimmt werden, der möglichst realistisch einen „Full Crawl“ wiederspiegelt (z.B. 90%). Sobald Dein Wert in den SETTINGS hinterlegt wurde, beginnt der crawlOPTIMIZER die Tage zu zählen, bis Dein Wert (z.B. 90%) erreicht ist. Sobald der Wert erreicht ist, werden die dafür gebrauchten Tage gespeichert und im Graphen dargestellt. So erhältst Du einen sehr guten Einblick, wie lange Google für einen vollen Crawl braucht. Dein Ziel sollte sein, mithilfe diverser Optimierungsmaßnahmen die Anzahl der Tage zu senken

Tipp: Pflege & überprüfe Deine XML-Sitemap(s) regelmäßig! In den XML-Sitemaps sollen nur Seiten aufgelistet werden, die relevant für Suchmaschinen (und somit Business-relevant) sind.

Tipp: Blockiere niemals URLs vom Crawling, die für Google Shopping ausgelegt sind, da ansonsten die Google Shopping Anzeigen von Google abgelehnt werden.

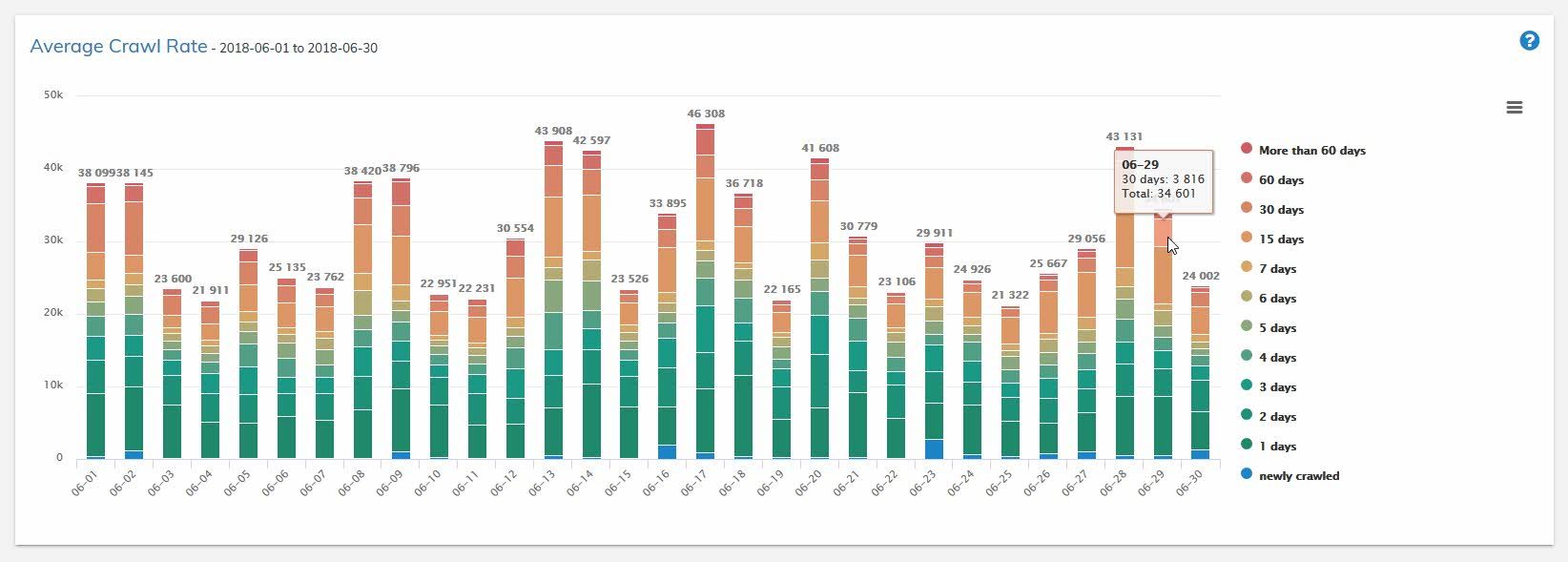

Unter Crawl-Frequenz versteht man die zeitliche Dauer in Tagen zwischen zwei Crawls einer URL. In dieser Grafik wird auf Tagesbasis die Crawl-Frequenz angezeigt. Du kannst eine Farbe im Balken klicken und bekommst dann automatisch alle URLs dieses Clusters im Logfile Exlorer vorgefiltert angezeigt.

Beispiel:

Die URL „xyz“ wurde am 25.05.2018 gecrawlt und das nächste Mal am 29.06.2018 – daraus ergibt sich eine Crawl-Frequenz von 35 Tagen. Diese URL wäre im orangefarbigen Abschnitt „30 days“ zu finden. Siehe Screenshot oberhalb.

In unserem Graphen siehst Du eine sinnvoll geclusterte Crawl-Frequenz von URLs auf Tagesebene.

Tipp: Du gewinnst, wenn Du es schafft Deine Business-relevanten Seiten häufiger gecrawlt zu bekommen als Deine Konkurrenz. In jedem Fall solltest Du Werte unter 15 Tagen anpeilen und merke Dir eines: Je höher die Crawl-Frequenz, umso besser!

Unsere Frequenz-Clusterung

Mehr als 60 Tage

60 Tage

30 Tage

15 Tage

7 Tage

6 Tage

5 Tage

4 Tage

3 Tage

2 Tage

1 Tag

Ganz neu gecrawlt

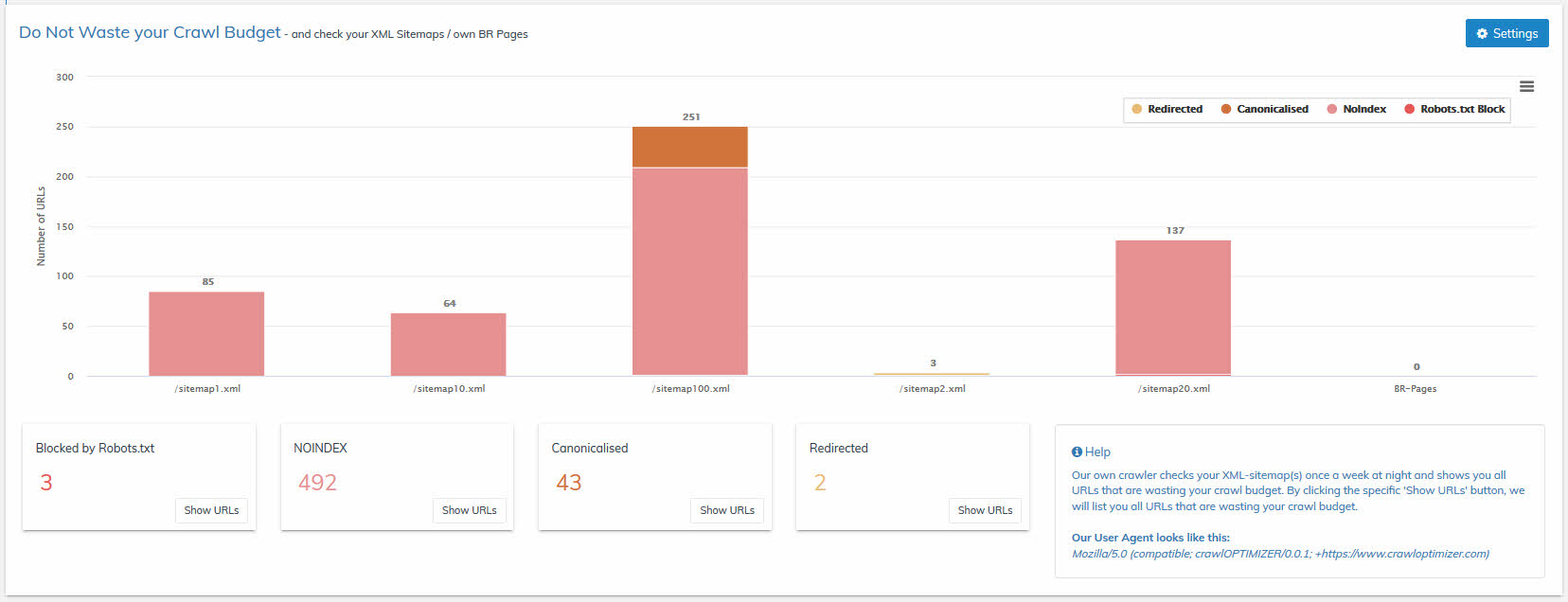

5. Crawl Budget Verschwendung

Wenn Deine Webseite über XML-Sitemap(s) verfügt, hast Du diese bestimmt schon in den SETTINGS hinterlegt (siehe oberhalb Punkt 3).

Gegebenenfalls hast Du auch noch weitere Busines-relevante Seiten manuell hinterlegt.

Wenn ja, perfekt! Denn all diese URLs werden von uns einmal in der Woche gecrawlt – yep, Du hast richtig gehört. Sie werden von uns regelmäßig kontrolliert.

Tipp: Verschwende nicht Deine kostbaren Google-Requests mit fehlerhaften URLs.

Wir haben dafür extra unseren eigenen Crawler gebaut, der einmal pro Woche nachts Deine XML-Sitemap(s) crawlt. Unser Crawler überprüft alle URL-Einträge, die in den Sitemaps vorkommen und die von Dir manuell hinterlegten URLs. Wir prüfen immer folgende Werte:

- Sind URLs enthalten, die durch Deine Robots.txt blockiert werden?

- Sind URLs enthalten, die dort nichts zu suchen haben, wie z.B. 404-URLs oder weitergeleitete URLs?

- Sind URLs enthalten, die in den Meta-Robots auf NOINDEX stehen?

- Sind URLs enthalten, die auf eine andere Seite mittels Canonical-Tag kanonisieren?

Wenn ja, überprüft bitte diese Seiten, korrigiert oder entfernt sie aus den Sitemaps, denn solche fehlerhaften URLs verbrauchen unnötig Dein kostbares Crawl Budget.

Du kannst Dir jederzeit alle fehlerhaften URLs ansehen, indem du einfach auf einen der Buttons „Show URLs“ klickst.

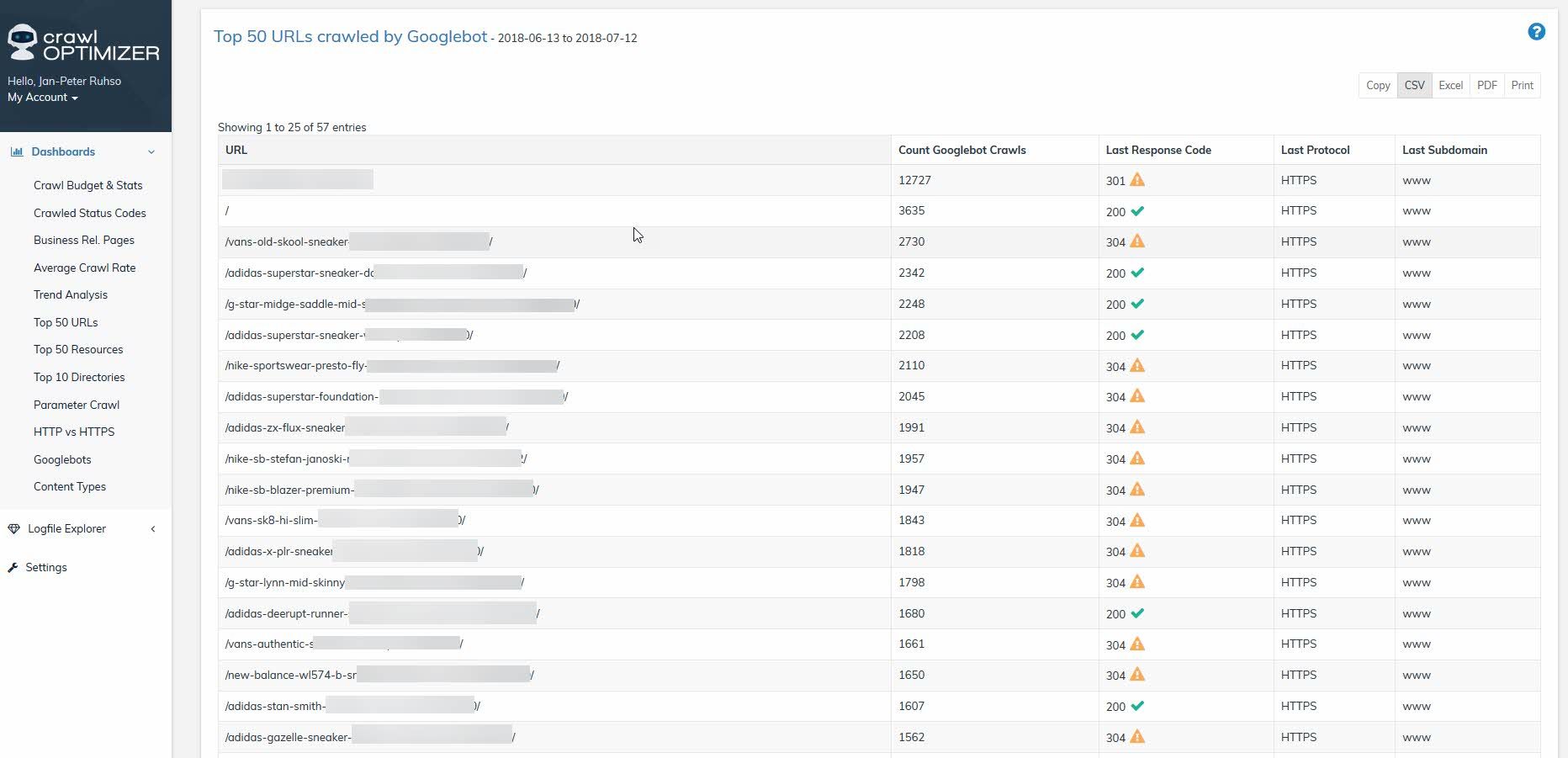

6. Top 50 URLs

In dieser Übersicht siehst Du auf einem Blick die Top-50 gecrawlten URLs in einem definierten Zeitraum. Der zuletzt gecrawlte Status Code wird ergänzend auch angezeigt.

Mit einem Klick auf eine URL gelangst Du in den Logfile Explorer (RAW DATA), wo Dir alle einzelnen Requests dieser URL aufgelistet werden.

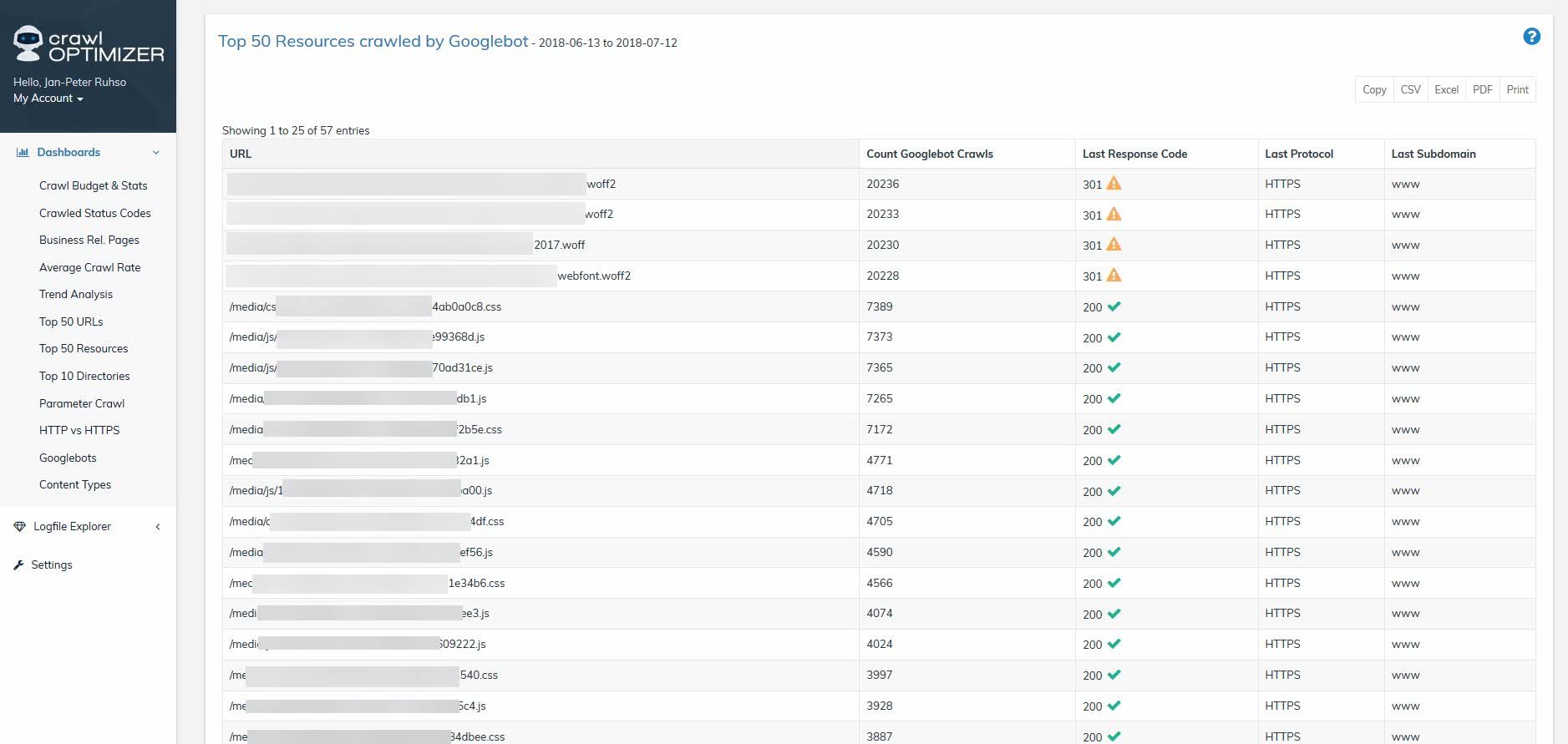

7. Top 50 Ressourcen

Im Gegensatz zur vorherigen Übersicht werden hier nicht die meist gecrawlten URLs angezeigt, sondern die meist gecrawlten Ressourcen (js/css/etc.). Auch hier wieder mit dem letzten, aktuellen Status Code.

Mit einem Klick auf eine URL gelangst Du auch hier wieder in den Logfile Explorer (RAW DATA), wo Dir alle einzelnen Requests dieser URL (Ressource) aufgelistet werden.

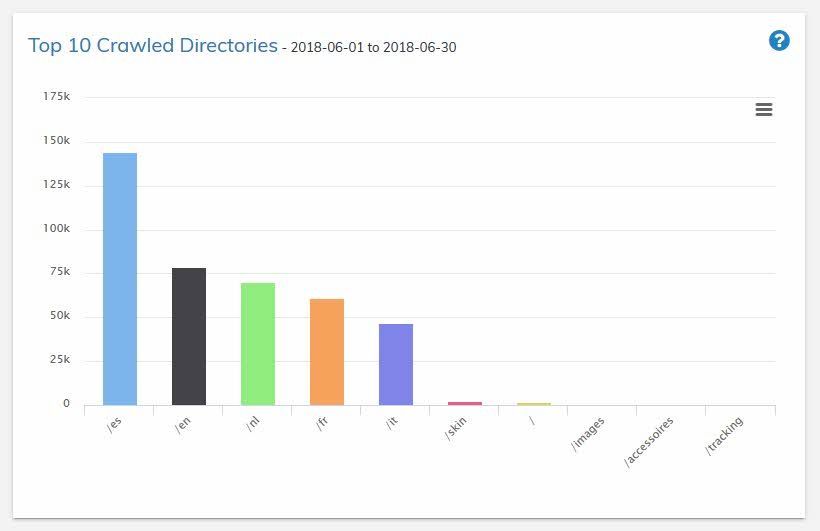

8. Top 10 Verzeichnisse

Welche Verzeichnisse werden am häufigsten gecrawlt? Eine oft gestellte, jedoch meist unbeantwortete Frage.

Unsere übersichtliche Grafik beantwortet Dir diese Frage auf einen Blick, um möglichst einfach OnPage-Optimierungsmaßnahmen ableiten zu können.

Du kannst Dir jederzeit alle Requests auf ein bestimmtes Verzeichnis im Logfile Explorer anzeigen lassen, indem Du im Graphen auf einen der Balken klickst.

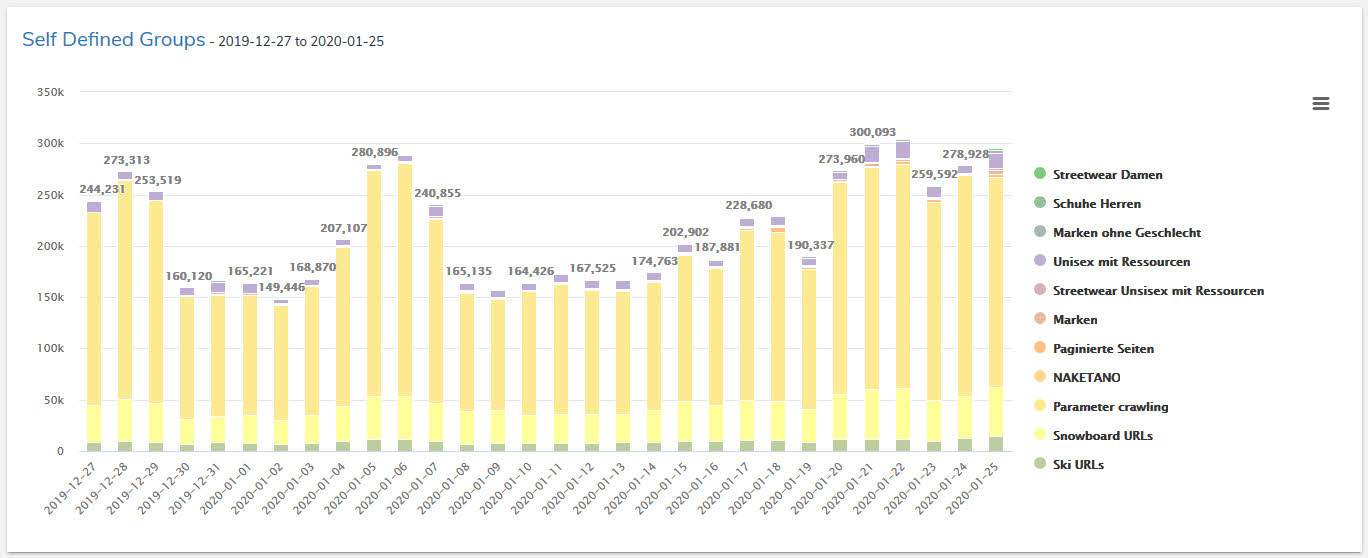

9. Selbst definierte Gruppen

Mittels einer einfachen REGEX-Abfrage (in den SETTINGS) kannst Du eigene URL-Gruppen definieren und so regelmäßig monitoren, wie häufig diese Gruppen gecrawlt werden. Wenn für Dich wichtige URL-Gruppen zu selten gecrawlt werden, solltest du Deine Webseitenarchitektur aus SEO-Sicht analysieren, dann schrittweise optimieren und den Fortschritt laufend im crawlOPTIMIZER messen.

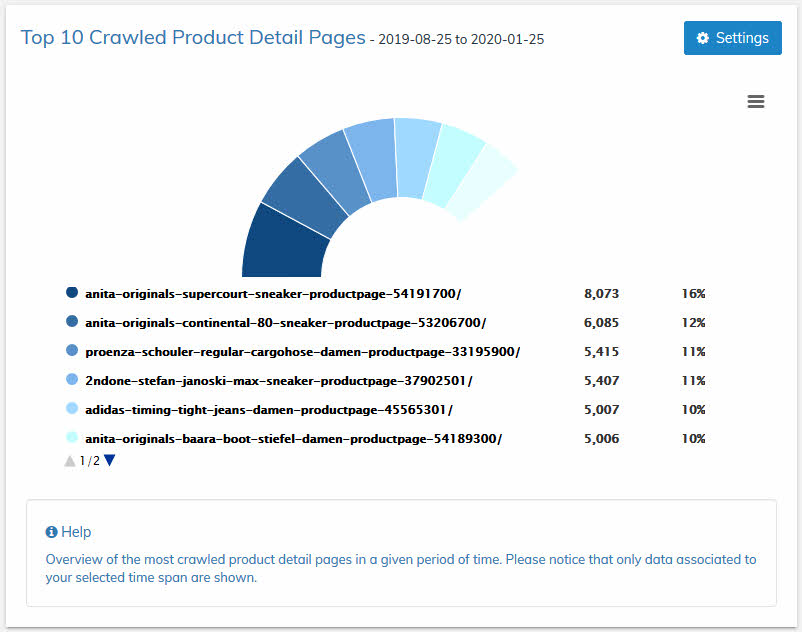

10. Top 10 Produkte

Du betreust einen Online-Shop? Dann ist diese Funktion für Dich perfekt geeignet. Mittels einmaliger, einfacher Hinterlegung eines Identifiers in den SETTINGS kannst Du Deine Produkte definieren und hast so jederzeit im Blick, welche Produkte vom Googlebot am häufigsten gecrawlt werden. Diese Information hilft Dir bei Deinen weiteren Analysen und Onsite-Optimierungen.

Wenn du im Graphen auf eine Produkt-URL klickst, wird Dir das Produkt auf Deiner Webseite angezeigt

Tipp: Solltest Du keinen Online-Shop betreiben, kannst Du in den SETTINGS auch einen anderen x-beliebigen Identifier hinterlegen und so monitoren.

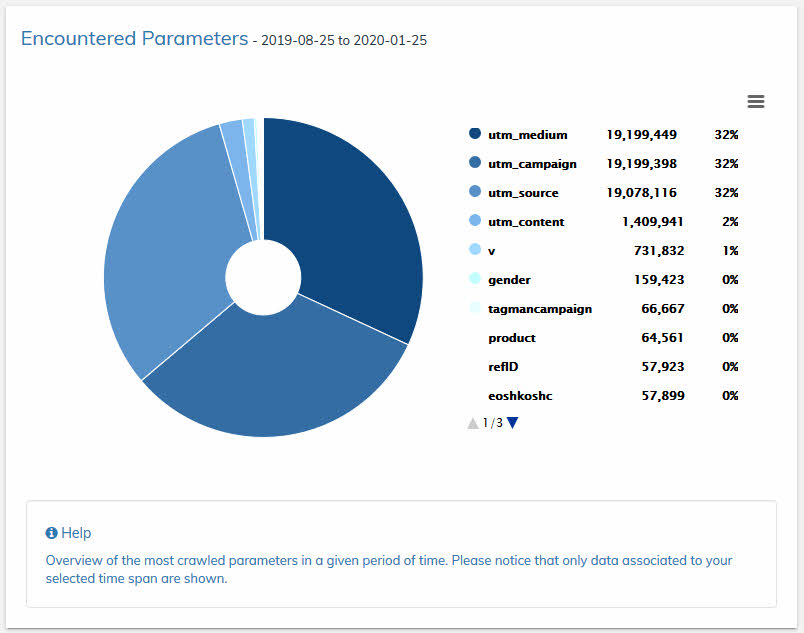

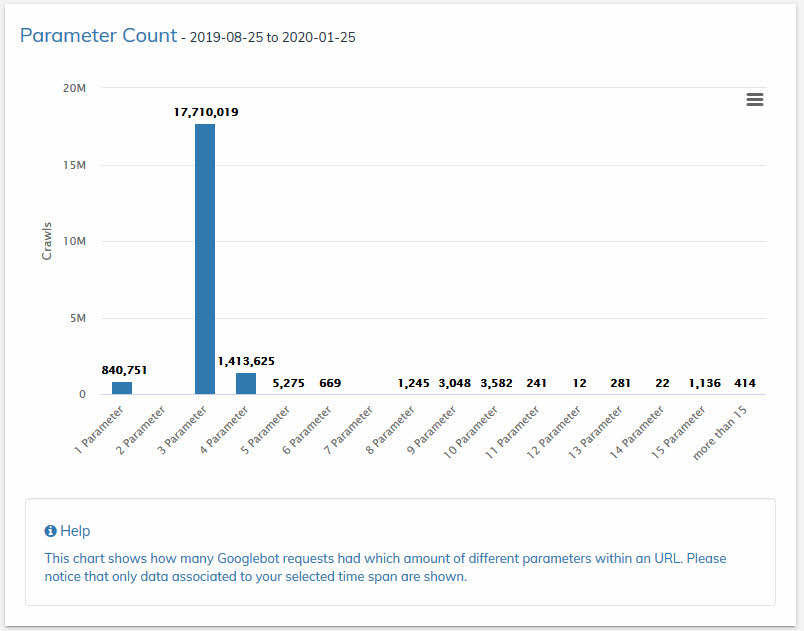

11. Gecrawlte Parameter

In diesen beiden Grafiken werden alle gecrawlten Parameter dargestellt, die in einem definierten Zeitraum gecrawlt wurden. Die zweite (untere) Grafik zeigt die Anzahl der gefundenen Parameter pro gecrawlter URL an. Dies hilft Muster zu erkennen.

Welche dieser Parameter beeinflussen maßgeblich den Inhalt Deiner Webseite und welche können vom Crawling ausgeschlossen werden? Analysiere die gefundenen Parameter mit größter Sorgfalt im Detail und steuere den Bot mit einer sauberen Webseitenarchitektur und/oder mit Vorsicht mit Deiner Robots.txt.

Tipp: Wenn Du aktiv Google-Shopping betreibst und Deine URLs im Shopping-Feed diverse (Tracking-)Parameter enthalten, darfst Du diese dort enthaltenen Parameter niemals mittels Deiner Robots.txt vom Crawling blockieren! Eine Blockierung hätte nämlich zur Folge, dass Deine Google-Shopping Anzeigen abgelehnt werden würden. Hinweis: Der normale (Search-)Googlebot crawlt den Shopping-Feed.

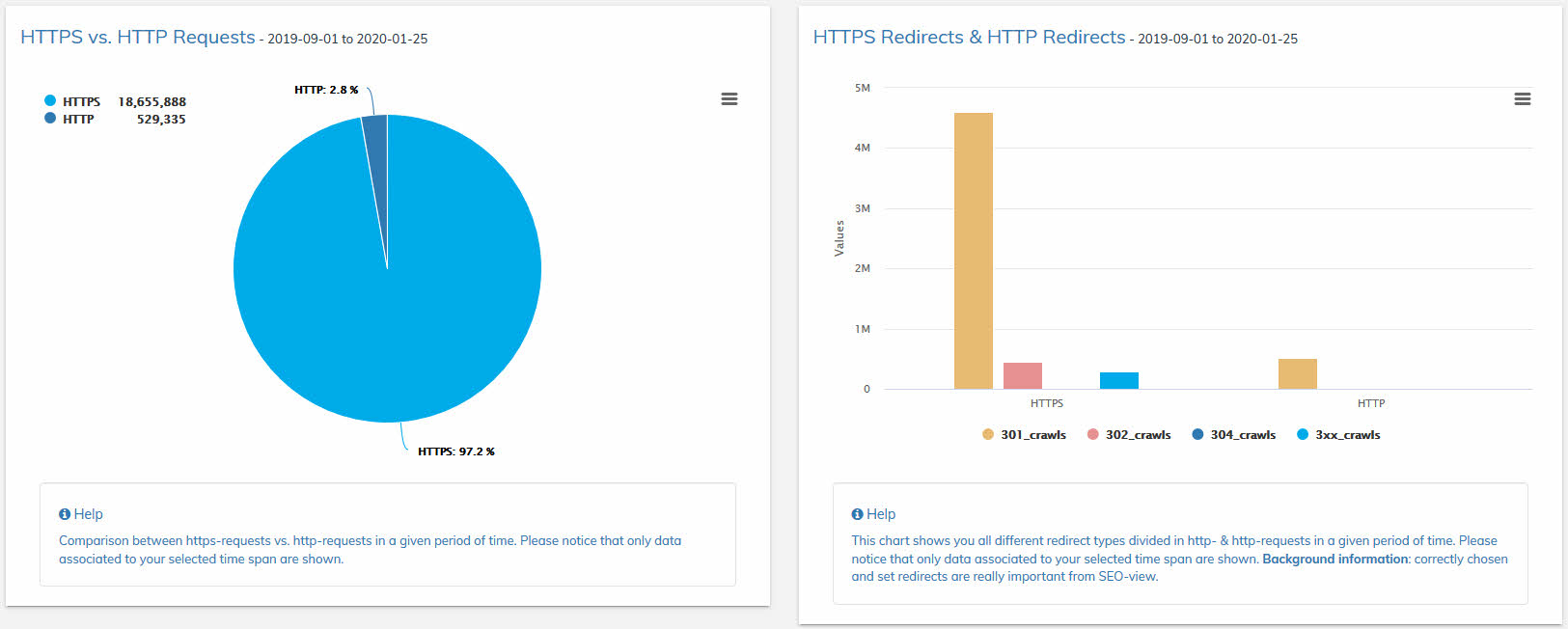

12. http vs. https Crawls & gefundene Redirects

In diesen beiden Graphen siehst Du, wie häufig Deine Seiten unter HTTPS bzw. HTTP gecrawlt wurden. Hilfreich ist diese Information, wenn HTTPS-Umstellungen bevorstehen, HTTPS-Umstellungen nicht korrekt umgesetzt wurden bzw. einfach zur nachträglichen Kontrolle. Weiteres siehst Du, welcher Redirect-Typ verwendet wird. Du kannst Dir jederzeit alle gefilterten Requests im Logfile Explorer anzeigen lassen, indem Du auf einen der Balken im Graphen klickst.

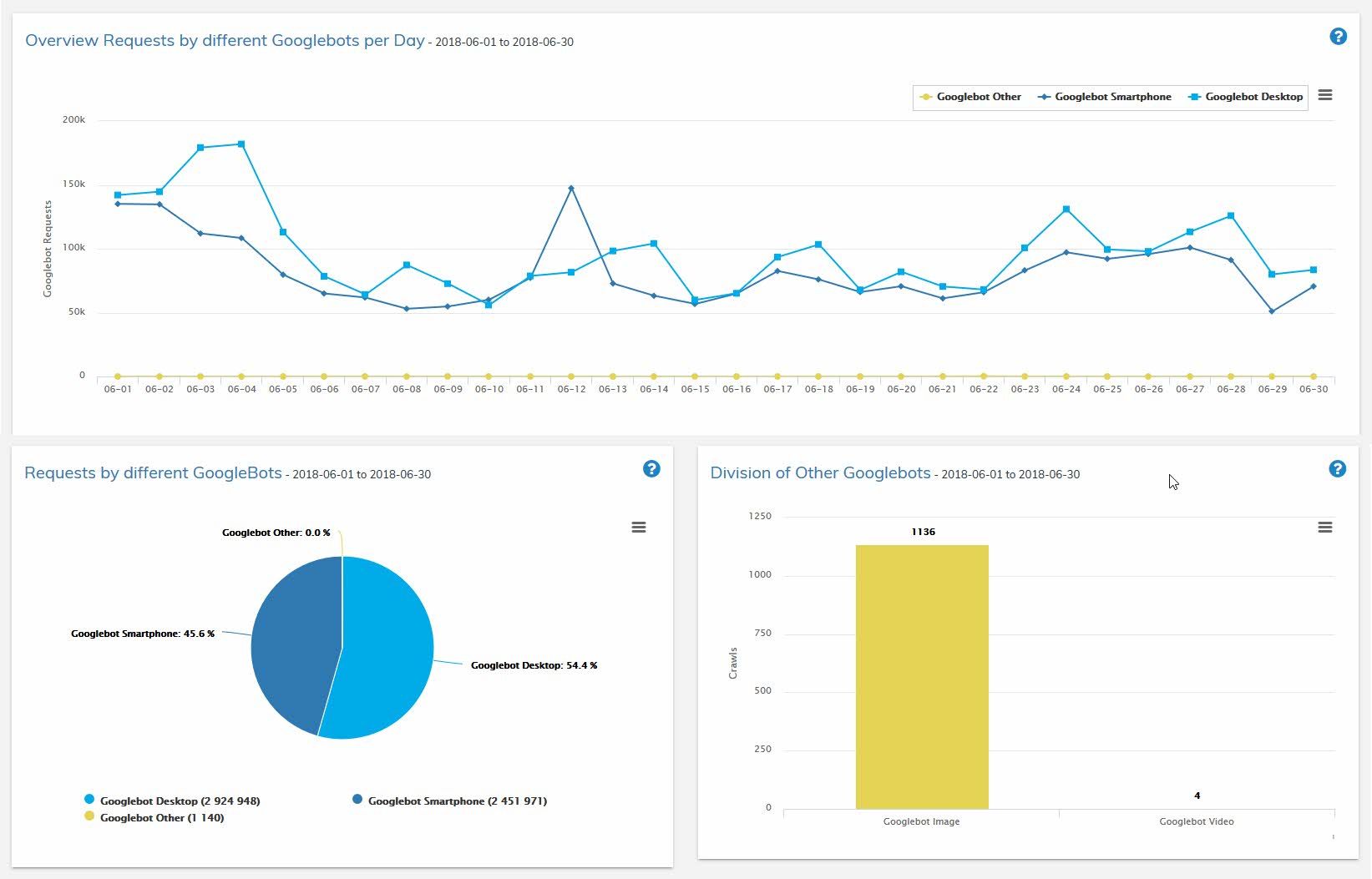

13. Unterschiedliche Googlebots

Es gibt viele verschiedene Googlebots. Hier siehst Du alle Googlebots, die Deine Webseite gecrawlt haben und mit welcher Häufigkeit. Wir haben für Dich die unterschiedlichen Googlebots sinnvoll geclustert, konkret in Googlebot Desktop, Googlebot Smartphone und Googlebot others.

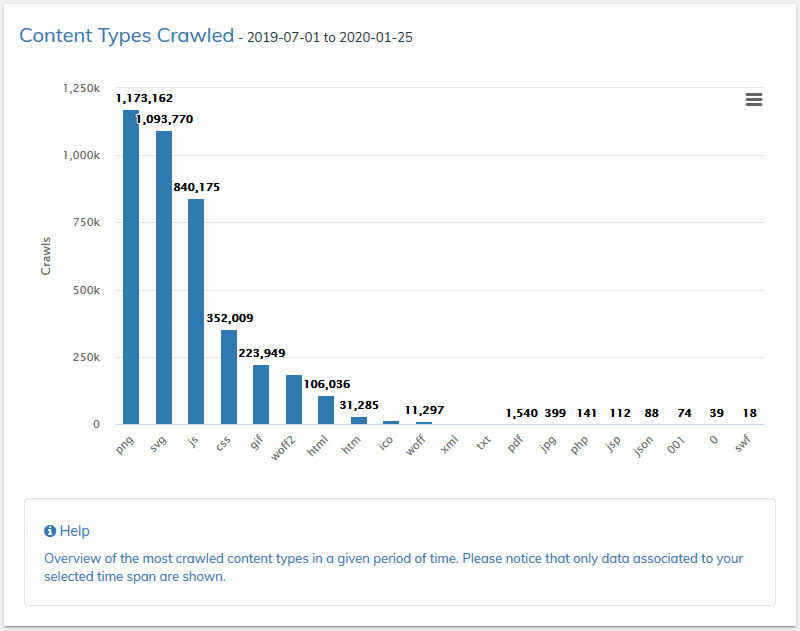

14. Content Types

In dieser Übersicht werden Dir die einzelnen, gecrawlten Content-Typen nach Häufigkeit angezeigt.

Du hast noch Fragen?